蕭簫 發自 凹非寺

量子位 報道 | 公眾號 QbitAI

一張圖片的焦距,能在老鼠玩具和日歷尺之間自由切換:

甚至能完成圖片上任一物體的對焦,呈現出不同物體在不同深度時的照片:

這張具有神奇魔力的圖片,就是集成了“全部物體信息”的全息圖。

生成這類全息圖,往往需要大量計算才能完成。

然而,來自MIT的團隊開發了一種新算法,不需要復雜儀器、也不需要等幾個小時,生成這樣一張全息圖,只需要在智能手機上耗費不到1秒的時間。

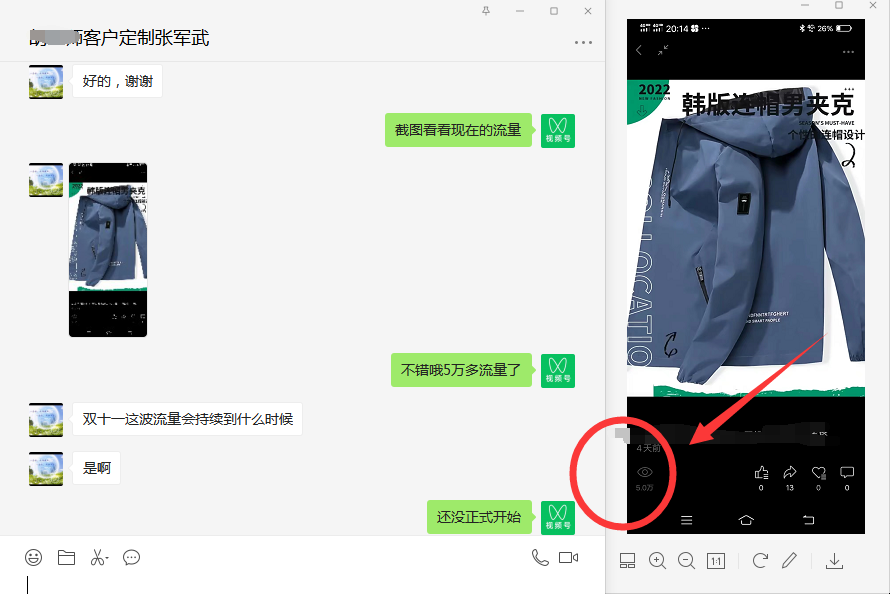

要知道,就在去年11月份,三星的科學家們生成3D全息視頻所用的處理器,尺寸還是太大,沒能整合到手機上:

那么,這種快速生成3D全息圖的方法,究竟是怎么做到的?

用神經網絡快速“切蛋糕”

首先,全息圖是什么?

舉個例子,visa信用卡上的鴿子,就利用了全息圖來做防偽標志。

全息圖即“全部的信息”,這種圖片包含物體的幅度和相位信息。

普通照相機,拍攝出來的照片只包含物體的幅度信息(亮暗),相位信息(遠近)卻無法直接保存。

這也是為什么,我們平時看見的2D照片“沒有立體感”。

此前,計算機要想360°全方位生成全息圖,通常得從多個角度進行干涉、衍射,再將相位信息拼合起來,與振幅信息疊加后生成圖片。

多角度生成相位信息,就像是在一個球形蛋糕上精準地切割8刀,將之分成8塊,對每塊進行相位重現:

然而,這種方法所需要的計算量往往巨大,耗時很久,完全無法在智能手機上運行。

因此,MIT團隊思考,能不能采用深度學習的方法,只通過3個角度,就把“蛋糕”分成8塊,來生成全息圖?

他們精挑細選出了4000張包含幅度、相位信息的圖像,以及這些圖像對應的3D全息圖,用來訓練神經網絡。

整體思路大致如下:獲取物體的相位信息后,生成點云,再結合殘差神經網絡,生成整體的全息圖。

那么,這種全息圖的效果如何呢?

可對焦任意物體,內存占用不到1MB

事實證明,利用神經網絡進行預測,只需要不到640KB的內存就能生成全息圖。

如果在消費級GPU上,這種神經網絡模型,每秒能生成60張分辨率為1080p的彩色3D全息圖。

而在智能手機如iPhone 11 Pro上,每秒能生成1.1張全息圖;至于Google Edge TPU上,每秒則能生成2張全息圖。

以動畫角色大雄兔(Big Buck Bunny)為例,右下角是它的深度圖。

從圖中可見,利用神經網絡(右)生成的全息圖像,幾乎和用原有方法(左)生成的全息圖像一模一樣。

而且,無論是遠處的小黃花,還是近處的兔子眼睛,都能完美對焦。

表面上看起來是一樣的話,具體到幅度和相位信息上如何呢?

從圖中可見,利用神經網絡預測的幅度和相位信息,也與真實值非常接近。

即使是現實中的照片,也與實際生成目標非常接近了。

當然,從細節來看的話,還是略微有一點差距。

相比于現有的VR和AR方案,3D全息圖是3D可視化的另一個實現方案。

但在使用VR的時候,用戶實際上是盯著2D顯示屏,產生3D錯覺,因此可能會產生視覺疲勞、頭暈等癥狀。

而3D全息圖則允許眼睛調整焦距,即交替地對前景和背景進行聚焦,能有效緩解這種癥狀。

下一步,團隊計劃添加眼球追蹤技術,讓用戶的眼睛看向哪里,哪里就生成部分高清全息圖。

在這種方案下,計算機只需要部分生成全息圖,實時運用下,效果也能更快更好。

以及,索尼贊助了這項研究,所以……

作者介紹

論文一作史亮,2014年畢業于北航,碩士畢業于斯坦福,目前于MIT就讀博士,研究方向包括VR/AR,以及機器學習和計算機圖形學。

論文二作李北辰,2018年畢業于清華大學,目前于MIT就讀博士,研究方向是機器學習在計算機圖形學中的應用。