9 月 26 日消息,英偉達此前推出了 Hopper H100 GPU,包括兩個版本,一個適用于 SXM5 和一個適用于 PCIe,顯存容量相同,均為 80 GB,但前者采用全新的 HBM3 標準,而后者采用 HBM2e 標準。

現在根據 s-ss.cc 的消息,NVIDIA 可能正在開發全新的 PCIe 版本的 Hopper H100 GPU。最重要的是,新顯卡可能不會配備 80 GB HBM2e,而是120GB HBM2e 顯存。

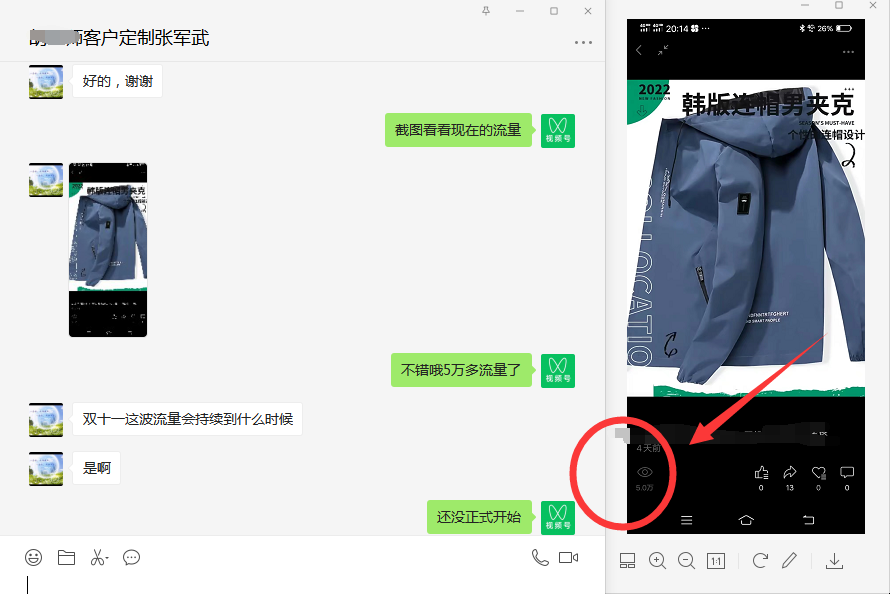

從下圖可以看到,他拿到了一款 ADLCE 的工程樣品卡,對于這張卡我們還沒有更進一步的消息,不過 120GB 顯存的 H100 GPU 就已經能夠讓人期待了。

新卡應該跟之前的版本相同,包括滿血 GH100 GPU,16896 個 CUDA,而且顯存帶寬將達到3TB / S,和 SXM 接口版本的 H100 核心與性能一樣。

爆料者指出,這款 H100 120GB PCIE 版本的單精度性能與 SXM 版本是相同的,單精度浮點性能約為 60TFLOPS。

GH100 GPU 的完整規格如下:

8 個 GPC,72 個 TPC(9 個 TPC / GPC),2 個 SM / TPC,每個完整 GPU 144 個 SM

每個 SM 128 個 FP32 CUDA 核心,每個完整 GPU 18432 個 FP32 CUDA 核心

每個 SM 4 個第四代 Tensor核心,每個完整 GPU 576 個

6 個 HBM3 或 HBM2e 堆棧,12 個 512 位內存控制器

60 MB 二級緩存

另外關于 ADLCE 工程樣品卡,這應該是 RTX4090 的 ES 工程樣品,但是 TDP 被限制在了 350W,所以單精度性能只有 60 多 TFLOPS。

IT之家了解到,H100 于 2022 年 4 月發布,由 800 億個晶體管組成,并采用了眾多開創性的技術,包括強大的全新Transformer引擎和NVIDIA NVLink互連技術,以加速最大規模的 AI 模型,如高級推薦系統和大型語言模型,并推動對話式 AI 和藥物發現等領域的創新。

英偉達表示,H100 使企業能夠削減 AI 的部署成本,相較于上一代,在提供相同 AI 性能的情況下,可將能效提高 3.5 倍,總體擁有成本減少至 1/3,所使用的服務器節點數也減少至 1/5。

NVIDIA DGX H100系統現在也已開始接受客戶預定。該系統包含 8 個 H100 GPU,FP8 精度的峰值性能達到 32 PFlops。每個 DGX 系統都包含NVIDIA Base Command 和 NVIDIA AI Enterprise 軟件,可實現從單一節點到NVIDIA DGX SuperPOD 的集群部署,為大型語言模型和其他大規模工作負載的高級 AI 開發工作提供支持。

全球領先的計算機制造商所提供的搭載 H100 的系統預計將在未來幾周內發貨,到今年年底將有超過 50 款服務器型號面市,2023 年上半年還將有數十款型號面市。已在構建系統的合作伙伴包括源訊(Atos)、思科、戴爾科技、富士通、技嘉科技、慧與、聯想和超微。

關鍵詞: